[IT] 엔비디아 Jetson Orin Nano 개발자 키트 상세정보: 손 안의 AI와 로봇 공학

- 1

- 2

안녕하십니까!! 심심해❤ 입니다.

번역기(DeepL)로 인한 오역이 있을 수 있습니다.

엔비디아 Jetson Orin Nano 상세정보: 손 안의 AI와 로봇 공학

NVIDIA 젯슨 오린 나노 개발자 키트: 소형 패키지에 담긴 강력하고 경제적인 AI 엣지 컴퓨팅

NVIDIA 젯슨 오린 나노 개발자 키트: 시작가: $199(4GB), $299(8GB)

새로운 NVIDIA 젯슨 오린 나노 개발자 키트는 합리적인 가격대로 이전 세대보다 대폭 향상된 성능을 제공합니다.

엔비디아는 현재 진행 중인 GTC 개발자 컨퍼런스에서 AI 개발을 위한 새로운 소프트웨어와 하드웨어를 발표하고 있습니다. 작년 이맘때, 엔비디아는 자사의 플래그십 AI 엣지 개발자 키트인 Jetson AGX Orin을 살펴볼 수 있는 기회를 제공한 바 있습니다. 2,000달러짜리 AI 및 로봇 플랫폼은 엄청난 성능, 컴팩트한 크기, 관리 가능한 전력 프로필을 갖춘 정말 인상적인 키트였습니다. 올해 이 회사는 하이엔드 컴퓨팅 플랫폼을 더 작은 대상에 맞게 축소하여 오늘 소개할 Jetson Orin Nano 개발자 키트를 선보이고 있습니다. 브랜드 이름에서 알 수 있듯이 이 개발자 키트는 지난 9월에 NVIDIA가 발표한 Jetson Orin Nano를 기반으로 합니다.

젯슨 오린 나노 개발자 키트: 타겟 고객과 경쟁사 비교

새로운 하드웨어와 함께 NVIDIA는 모든 Orin 장치에 새로운 기능과 상당한 성능 향상을 제공하는 Jetpack 소프트웨어 개발 키트(SDK)의 대규모 업데이트도 함께 발표했습니다. 확장된 하드웨어 기능과 더욱 최적화된 소프트웨어 환경을 통해 NVIDIA는 Jetson Orin Nano 개발 키트가 이전 세대 Jetson Xavier보다 2배 이상 빠르며, 특히 AI 중심 작업에서 0.47에서 40 8비트 정수(INT8) TOPS로 도약하는 등 무려 80배(예, 80배) 더 빠르다고 약속합니다. 32비트 부동 소수점 계산 성능은 Jetson Nano의 5.4배에 불과하지만, 그럼에도 불구하고 비슷한 전력 소비량과 함께 성능이 크게 향상되어 절대 성능과 와트당 성능이 매우 크게 향상되었습니다.

앞서 언급한 바와 같이, 이 개발자 키트는 Jetson AGX Orin 개발자 키트와 동일한 기술을 기반으로 구축되었지만 더 낮은 전력 범위와 더 낮은 가격대를 위해 축소된 새로운 Jetson Orin Nano를 기반으로 합니다. 이 새로운 Nano와 이전 버전 간의 성능 차이는 대부분 맥스웰 기반 Jetson Nano에는 없던 텐서 코어가 Jetson Orin Nano의 GPU에 탑재되어 있다는 점과 관련이 있습니다. 현재 닌텐도 스위치에서 볼 수 있는 테그라 X1의 축소 버전인 오리지널 젯슨 나노는 매우 저렴한 가격대의 훌륭한 교육용 도구입니다. 하지만 전용 AI 하드웨어가 부족하고 메모리가 제한되어 있다는 점을 고려하면 이전 세대는 방대한 데이터 세트가 있는 오늘날의 AI 모델 작업에는 적합하지 않으며, 이것이 바로 Jetson Orin Nano가 등장하는 이유입니다.

한 가지 중요한 점은 이 플랫폼이 방금 살펴본 AMD 자일링스 KR260 로보틱스 스타터 키트와는 매우 다른 종류의 플랫폼이라는 점입니다. Jetson Orin Nano는 NVIDIA의 GPU 기술을 통한 머신 러닝에 중점을 두는 반면, KR260은 산업용 로봇 공학용이며 다른 IO 세트가 특징이며 FPGA 기술에 의존합니다. 온보드 연결성 측면에서는 이미지 및 비디오 처리와 인식이라는 비슷한 타겟층을 공유하는 (매우 유사한) KV260 AI 비전 스타터 키트와 다소 유사하며, 이 역시 FPGA를 사용합니다. 생산 모듈의 가격도 상당히 비슷합니다. AMD Xilinx K26은 이 시점에서 꽤 잘 알려진 제품인 반면, Jetson Orin Nano는 완전히 새로운 제품이며, NVIDIA의 관점에서 볼 때 기존 시장에 비해 한 단계 더 높은 가치를 지니고 있습니다. 이에 대해서는 나중에 더 자세히 설명할 예정이니 기대해 주시기 바랍니다.

하드웨어에 대해 자세히 알아보기 전에 지난 12개월 동안 Jetpack SDK가 어떻게 발전해 왔는지 살펴보겠습니다.

NVIDIA Jetpack SDK의 도약

2022년 4월 Jetpack 5.0이 출시된 이후, NVIDIA는 머신 러닝 도구의 성능을 개선하기 위해 열심히 노력해 왔습니다. NVIDIA는 머신 러닝에서 오리지널 Jetson Nano에 비해 80배 뛰어난 성능을 자랑하는 Jetson Orin Nano를 선전해 왔지만, 앞서 언급했듯이 오리지널에는 텐서 코어가 없습니다. 따라서 이러한 엄청난 성능 도약이 완전히 예상치 못한 것은 아닙니다. 하지만 그 중 상당 부분은 그 아래에서 실행되는 소프트웨어에 직접적으로 기인합니다: 바로 Jetpack 버전 5.1입니다.

5.0에서 버전이 소폭 상승한 것처럼 보이지만, 최신 버전의 Jetpack은 지난 12개월 동안 고도로 최적화되어 AI 중심 작업에서 54%의 추가 성능 향상을 이끌어냈습니다. 오늘은 툴킷의 프리뷰 버전을 살펴보고 있지만, NVIDIA는 아직 끝나지 않았으며 향후 몇 달 동안 Jetpack에 대한 추가 개선이 이루어질 것으로 기대한다고 말합니다. 실제로 NVIDIA 플랫폼에서 소프트웨어를 작성해 본 적이 있다면 이미 이러한 속도 향상을 경험해 보셨을 것입니다. NVIDIA의 문서에 따르면 Jetpack 5.1.0은 지난 1월에 Jetson Orin NX 16GB에 대한 지원을 추가했습니다.

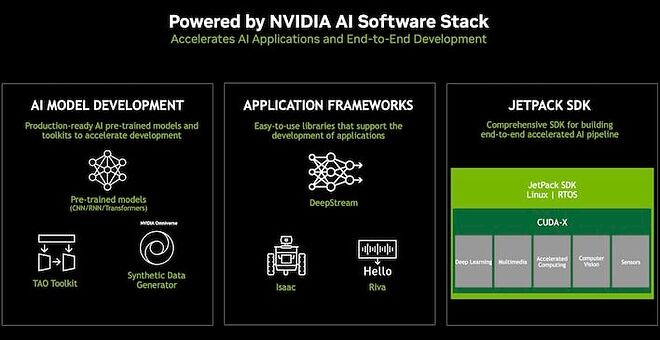

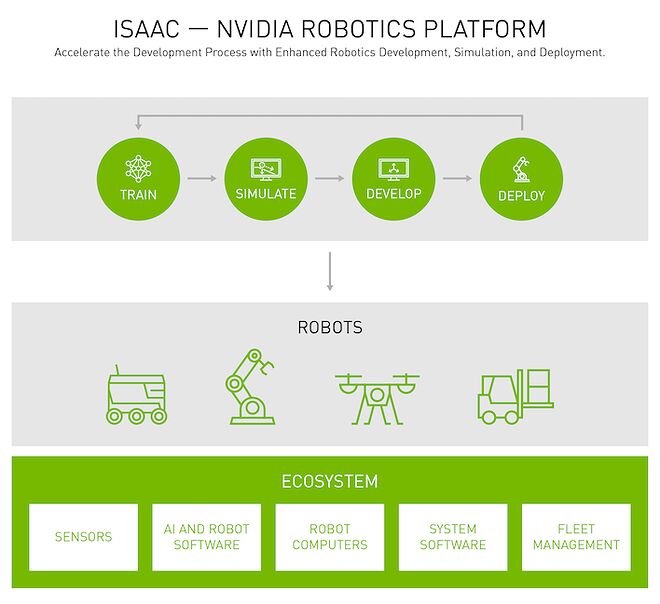

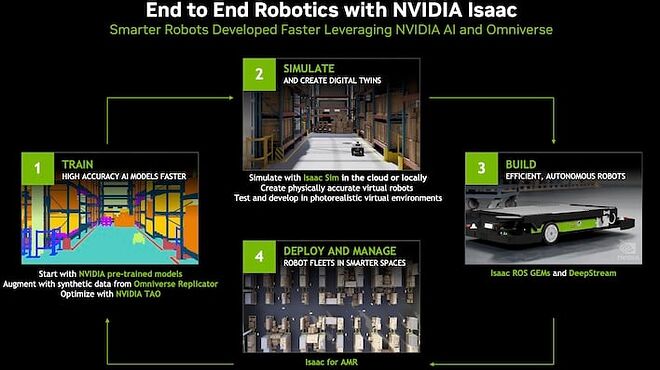

Jetpack은 개발자가 수동으로 소프트웨어를 작성할 필요 없이 텐서 코어 또는 GPU를 직접 다루고 트레이닝과 추론을 바로 수행할 수 있는 포괄적인 라이브러리 및 API 제품군입니다. 또한 전체 로보틱스 스택을 포괄하는 로봇 플랫폼으로, 로봇 OS 2(줄여서 ROS 2)를 기반으로 구축되었습니다. 엔비디아는 이 로봇 플랫폼을 ISAAC이라고 부르며, AI 모델 트레이닝 및 빌드 시뮬레이션부터 생산 유닛 배포 및 차량 관리에 이르는 모든 프로세스 단계를 포괄합니다. 오늘 데모에서는 컴퓨터 생성 콘텐츠를 사용하여 모델 훈련 및 최적화 프로세스를 살펴볼 수 있었으며, 추가 훈련을 받은 모델이 얼마나 더 최적화되었는지 확인할 수 있습니다.

이러한 개념이 특별히 새로운 것은 아니지만, NVIDIA는 꽤 오랫동안 이러한 개념을 추진해 왔기 때문에 버전 5의 모든 툴이 업데이트되었습니다. SDK에는 이미지 분류 및 세분화, 신경망 지원, 카메라 및 비전 API, 최신 버전의 벌칸 등을 위한 툴이 포함되어 있습니다. 이러한 노력의 결실 중 일부는 곧 Jetson Orin Nano 개발자 키트를 살펴보면서 시연해 보겠습니다. 이제 더 이상 고민하지 말고 하드웨어에 대해 살펴보겠습니다.

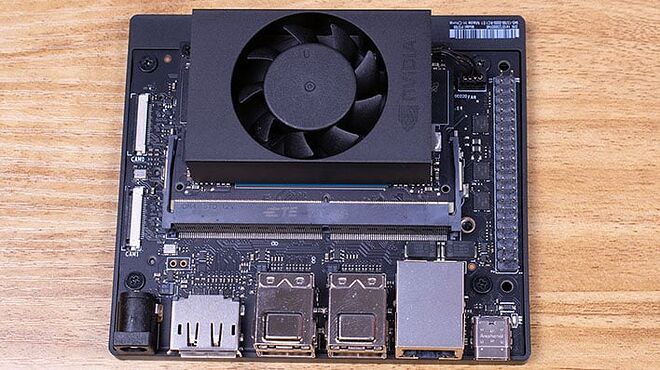

Jetson Orin Nano 개발자 키트 소개

Jetson Orin Nano 개발자 키트를 소개합니다. 이 작은 시스템은 얼마 전에 살펴본 60달러짜리 Jetson Nano 2GB보다 훨씬 더 Jetson AGX Orin 개발자 키트와 비슷해 보입니다. 하지만 앞서 살펴본 바와 같이 NVIDIA는 이 하드웨어를 크게 강화했습니다. 두 키트 모두 동일한 기술을 기반으로 하므로 이 키트를 형제와 비교하는 것이 더 유용합니다. 이 개발자 키트는 지난 9월에 NVIDIA가 발표한 Jetson Orin Nano를 기반으로 합니다. 위의 표에 기본 사항을 정리해 두었으니 이제 비교를 시작하겠습니다.

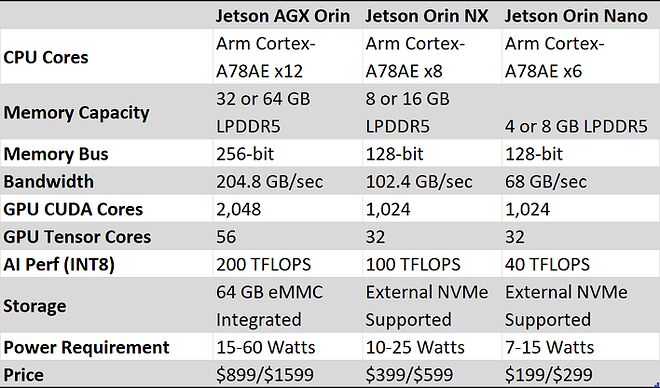

가장 큰 차이점은 SoM에서 사용 가능한 리소스와 가격대입니다. Jetson AGX Orin 개발자 키트에는 12개의 Arm64 Cortex-A78AE 코어, 204GB/s의 메모리 대역폭을 갖춘 32GB의 LPDDR5 메모리, 2048코어 Volta 기반 GPU가 있는 반면, Jetson Orin Nano는 모든 것이 축소되어 있습니다. 하지만 한 가지 중요한 예외를 제외하고는 Jetson Orin Nano가 의도한 사용자를 위한 충분한 리소스를 갖추고 있다는 데는 의심의 여지가 없습니다. 6개의 Cortex-A78AE 코어와 1024개의 CUDA 코어는 더 큰 형제의 정확히 50%입니다. 하지만 8GB의 LPDDR5 메모리는 용량의 4분의 1에 불과하며, 더 낮은 속도와 버스 폭 감소로 인해 유효 대역폭이 정확히 1/3인 68GB/s에 불과합니다.

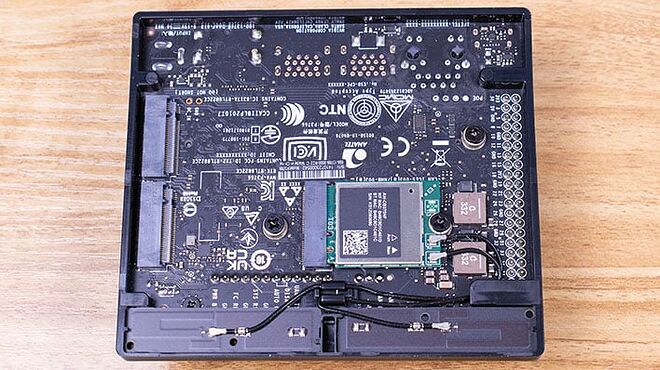

물론 여기에는 몇 가지 장점도 있습니다. Jetson Orin Nano의 열 예산은 7와트 또는 최대 15와트이므로 전력만 소모합니다. 또한 저가형 버전에는 eMMC 스토리지가 없는 반면, AGX 버전에는 Linux가 사전 설치된 64GB의 온보드 스토리지가 있습니다. 대신 NVIDIA에서 Jetson 5.1.1 프리뷰와 함께 사전 플래시된 마이크로 SD 카드를 사용해야 합니다. 이는 다른 저가형 개발 플랫폼과 다르지 않습니다. 예를 들어, MiSTer FPGA 프로젝트에서 볼 수 있는 Terasic DE10-nano와 같은 FPGA 디바이스나 KV260 또는 KR260 스타터 키트와 같은 AMD Xilinx K26 플랫폼도 마찬가지입니다. 더 저렴하지만 훨씬 약하고 여전히 매우 희소성이 높은 Raspberry Pi 4와 같은 다른 Arm64 기반 머신도 마찬가지입니다.

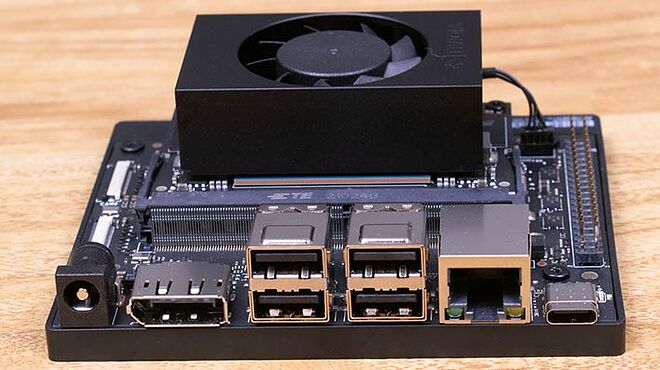

나머지 NVIDIA 젯슨 오린 나노 개발자 키트에는 캐리어 보드가 포함되어 있으며, 이 보드에는 젯팩이 지원하는 거의 모든 작업을 수행하기에 충분한 IO가 있습니다. USB 3.0 포트 4개, DisplayPort 1.4 비디오 출력, USB 3.1 Gen 1 Type-C(DP Alt 모드를 통해 비디오를 전송), 40핀 GPIO 핀 어레이, 22핀 리본 케이블 카메라 연결 한 쌍이 있습니다.

네트워크 연결은 유선 기가비트 이더넷과 802.11ac Wi-Fi 및 Bluetooth 5.0이 보드에 통합된 형태로 제공되며, 장치 하단에 안테나가 있습니다. 길이가 80밀리미터 또는 30밀리미터인 NVMe SSD에 적합한 한 쌍의 M.2 포트도 있지만, 현재는 SoM에 통합된 SD 카드 포트를 사용하고 있습니다. HDMI 포트가 없는 것이 눈에 띄지만, 필요한 경우 디스플레이포트-HDMI 어댑터가 매우 저렴하다는 점을 NVIDIA는 정확하게 지적합니다. 전원은 19v 배럴 잭으로 공급되며 NVIDIA는 개발자 키트와 함께 상자에 45와트 AC 어댑터를 포함합니다.

젯슨 오린 제품군 라인업

또한 오늘부터 구매할 수 있는 몇 가지 프로덕션 모듈도 있다는 점도 언급해야 합니다. 앞서 살펴봤거나 현재 검토 중인 세 가지 개발 플랫폼과 함께 총 6개의 프로덕션 모델이 출시될 예정입니다.

가장 아래쪽, 모든 Orin 모델 아래에는 이전 세대 Jetson Nano 개발자 키트가 있으며, 이 키트는 4GB 버전으로만 유지됩니다. 이 모델은 교육용 엔트리 레벨 플랫폼으로서 149달러의 가격대에서 흔들리지 않았습니다. 개발 작업을 수행하기에 충분한 성능이지만, 대형 모델에는 많은 RAM이 필요하지만 이 모델에는 부족하고 맥스웰 기반 GPU에는 텐서 코어가 없습니다. 이러한 한계로 인해 다른 모든 사람들은 AI 가속 기능이 있는 모델을 원할 것입니다.

현재 Orin 제품군에는 6개의 제품이 있으며, 그 중 가장 낮은 제품이 오늘 살펴볼 제품입니다. 이 키트의 기반이 되는 Jetson Orin Nano 생산 모듈은 각각 199달러 또는 299달러의 가격으로 4GB 및 8GB 모델로 제공됩니다. 8GB Nano의 299달러 가격과 Jetson Orin Nano 개발자 키트의 499달러 가격을 비교하면 추가 비용으로 인해 총 비용이 약 200달러 추가되는 것을 알 수 있으며, 이는 상당히 합리적인 가격입니다. 하지만 이 개발자 키트의 교육용 가격은 20% 할인된 399달러에 불과하기 때문에 교육용 사용자에게는 더욱 좋습니다. 개발자 키트와 프로덕션 모델 모두 머신 러닝 작업에 대해 40 TOPS 등급을 받았으며, 앞서 언급했듯이 이전 Jetson Nano보다 80배 빠른 속도라고 말합니다.

중간급 모델인 Jetson Orin NX는 8GB 및 16GB 버전으로 Xavier NX를 대체합니다. 이들은 10~25와트의 TDP, 전체 102GB/s의 메모리 대역폭, 1,024개의 CUDA 코어와 32개의 텐서 코어를 갖춘 볼타 기반 GPU로 구성할 수 있습니다. 두 배로 늘어난 텐서 코어 예산과 더 높은 열 헤드룸으로 인해 머신 러닝 성능은 100 TOP에 이릅니다. 이에 따라 가격은 8GB 모델이 399달러, 16GB 버전이 599달러로 책정될 예정이지만, 그 외에는 동일하게 책정될 것으로 보입니다. 16GB 버전은 한동안 699달러에 판매되었기 때문에 가격이 인하됩니다. 8GB 모델은 더 낮은 가격대로 새롭게 출시되었습니다. Jetson Orin NX를 기반으로 하는 개발자 키트는 없지만, Jetson AGX Orin 개발자 키트에는 리소스 및 열 예산 시뮬레이션을 위한 모드가 내장되어 있으므로 이러한 고가 모델을 직접 타겟팅할 수 있습니다.

마지막으로 최상위에는 32GB 및 64GB 버전의 Jetson AGX Orin이 있습니다. 이 버전은 개발자 키트와 완전히 동일한 2,048코어 GPU(56개의 텐서 코어 포함), 204GB의 LPDDR5 메모리, 64GB의 eMMC를 갖추고 있습니다. 그러나 이 모듈에는 Arm64 CPU 코어가 8개만 활성화되어 있는 반면 개발자 키트에는 12개까지 활성화되어 있습니다. 그럼에도 불구하고 열 및 전력 요구 사항은 최대 60와트에서 변하지 않았으며, 275 TOPS의 추론 마력도 변하지 않았습니다. 32GB 모델은 999달러에 판매되었지만 899달러로 가격이 인하될 예정입니다. 새로운 64GB 버전은 1,599달러로 책정될 예정입니다.

이제 Jetson Orin Nano에 대해 자세히 알아보고 어떤 기능을 수행할 수 있는지 알아볼 차례입니다. 다음 시간에는 이 작은 머신 러닝 파워하우스에서 몇 가지 AI 워크로드를 살펴볼 예정이니 기대해 주세요.

NVIDIA의 Jetpack 5.1 SDK 및 ISAAC 실험 및 주요 시사점

새로운 나노 아키텍처에 대한 지원이 포함된 Jetpack 5.1.1의 프리뷰 버전으로 Jetson Orin Nano 개발자 키트를 테스트했습니다. 64GB SD 카드에 사전 플래시된 상태로 제공되었지만 다른 설정 작업이 완료되지 않았기 때문에 시스템을 시작할 때 사용자 계정을 만들고 일반적인 Ubuntu 데스크탑 시작 절차를 진행해야 했습니다. 즉, 이 키트의 구매자가 경험하는 것과 똑같은 신선한 경험을 바로 할 수 있었습니다.

AI 엣지 디바이스 벤치마킹

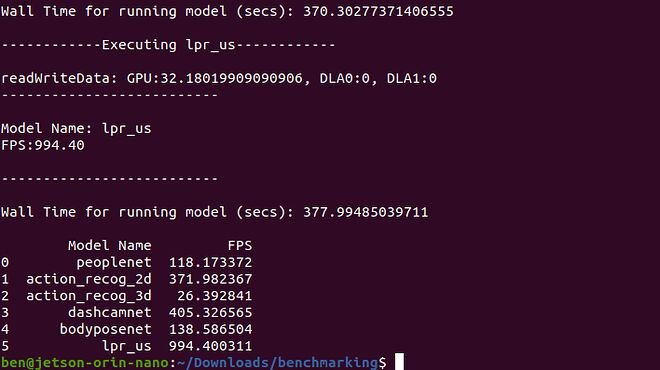

Jetson AGX Orin 개발자 키트에서 했던 것과 마찬가지로, 회사에서 제공하는 스크립트 벤치마크를 통해 Jetson Orin Nano의 AI 기능을 테스트할 수 있었습니다. 이 스크립트에는 NVIDIA 하드웨어에서 NVIDIA가 제공하는 AI 모델을 실행하는 것이 포함되며, GPU의 Tensor 코어용으로 제작되었기 때문에 여러 플랫폼에 실제로 적용되지는 않습니다. 안타깝게도, 예를 들어 AMD Xilinx의 Kria KR260 또는 KV260과 같은 다른 AI 플랫폼과 직접 비교할 수는 없지만 괜찮습니다.

각 테스트는 사전 녹화된 비디오에 대해 모델을 실행하고 성능을 측정하는 데 7~10분 정도 소요됩니다. 메트릭은 초당 비디오 프레임 수로 표시되어 있으며, 보시다시피 대부분의 메트릭이 실시간보다 빠르게 실행되며 일부의 경우 실시간보다 훨씬 빠르게 실행됩니다. 한 가지 예외는 3D 비디오의 동작 인식인데, 이 기능은 두 대의 카메라에서 촬영한 스테레오 비디오를 사용하여 AI 모델이 사람의 눈처럼 두 비디오를 오버레이하여 깊이를 유추할 수 있도록 합니다.

이러한 결과를 이전 Jetpack 5.0을 실행하는 Jetson AGX Orin 개발자 키트에서 얻은 결과와 비교하면 새로 향상된 Jetpack 5.1 SDK를 사용하더라도 여전히 큰 성능 차이가 있음을 알 수 있습니다. 그러나 인용된 INT8 TOPS 사양은 AGX 오린이 6배 이상 유리하지만, 이 벤치마크에서는 더 빠른 오린이 약 4배 더 빠릅니다. 이러한 개선이 없었다면 성능은 훨씬 더 낮았을 것이기 때문에 그 자체만으로도 지난 12개월 동안 Jetpack이 얼마나 발전했는지 알 수 있습니다.

ISAAC과 학습 머신

또한 VMWare Horizon을 통해 NVIDIA의 클라우드 플랫폼에 대한 전체 액세스 권한도 얻을 수 있었습니다. 이를 통해 엔드투엔드 워크플로 상황에서 ISAAC의 AI 모델링을 사용할 수 있었습니다. NVIDIA는 모든 개발자에게 다양한 작업을 위해 사전 학습된 여러 AI 모델을 제공하며, 개발자는 클라우드에서 AI가 사용하고 학습할 수 있는 추가 자료를 생성하여 모델의 학습을 미세 조정할 수 있는 옵션을 제공합니다.

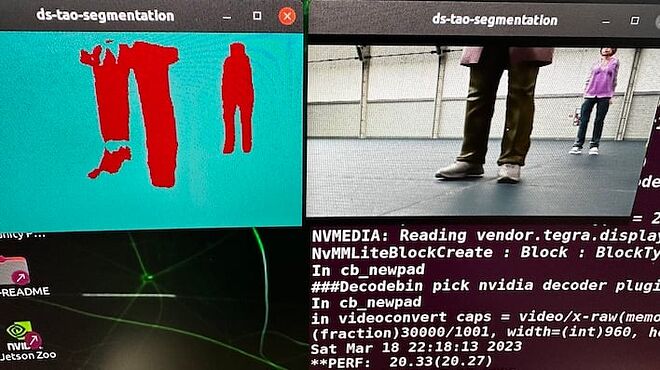

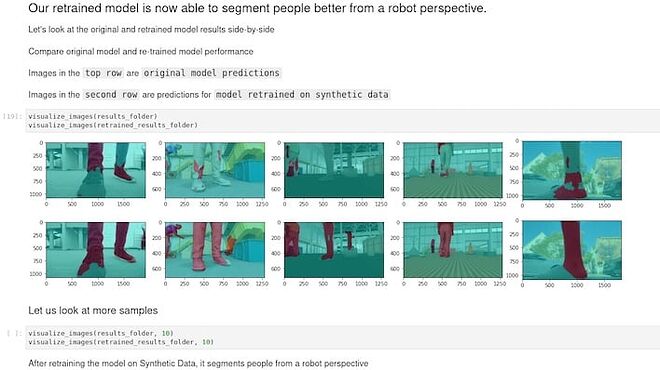

저희는 NVIDIA의 엔터프라이즈 클라우드 서비스인 NGC의 사람 세분화 모델을 사용했습니다. 이 모델은 이미 다양한 카메라 높이, 군중 밀도, 시야각이 포함된 데이터 세트로 훈련된 상태였습니다. 하지만 이는 시작용 모델일 뿐이며, NVIDIA 자체에서도 이 모델을 지상 로봇에 사용하면 원래 데이터 세트에 적절한 카메라 각도가 포함되어 있지 않아 정확도가 떨어질 수 있다고 말합니다.

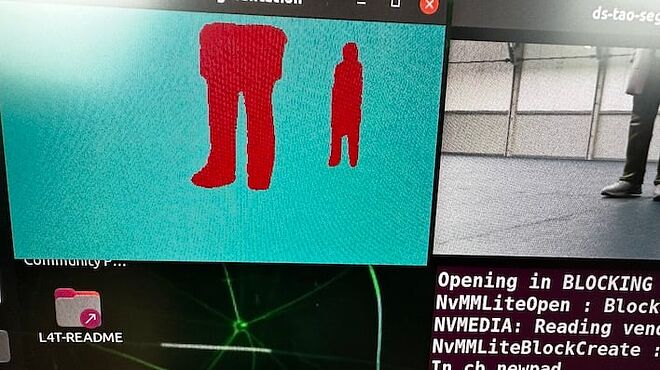

빨간색은 AI가 인식하는 장애물을 나타냅니다. 움직일 때 이 표시가 깜박이면 로봇이 사용자를 보지 못할 수 있습니다.

대신 NVIDIA의 AI 절차적 툴을 사용하여 로우다운 로봇이 어디로 가는지 확인하는 데 필요한 정확한 카메라 각도를 가진 비디오를 생성할 수 있었습니다. ISAAC Sim의 Omniverse Replicator를 사용하여 장면, 오브젝트, 사람을 생성하고 무작위화를 추가하여 데이터에 추가적인 변형을 생성했습니다. OR에서 생성된 합성 데이터에는 이미 주석이 추가되어 있으므로 AI 학습 부분이 무엇을 보고 있는지 정확히 알 수 있습니다.

먼저 사전 학습된 모델을 다운로드하고, AI 애플리케이션을 호스팅하는 Docker 컨테이너에서 실행하고, Docker 컨테이너에 저장된 애플리케이션에서 실행하는 것으로 시작했습니다. AI 학습이 완료되면 다시 실행하여 작업 결과를 확인할 수 있습니다. 하지만 현재로서는 이 모델이 신발을 잘 인식하지 못한다는 점을 확인해야 합니다. 위 사진에서 왼쪽 이미지는 로봇이 감지한 것이고, 오른쪽 이미지는 시뮬레이션에서 실제로 본 것입니다.

결과적으로 이 모델만 학습한 로봇은 창고를 가로질러 걸어갈 때 사용자의 발을 보지 못하고 발가락을 부수고 지나갈 수 있습니다. 이런 일이 발생하면 안 되므로 최적화를 시작하겠습니다.

최적화 전과 후의 AI 모델로 데이터를 시각화하면 정확도가 크게 향상됩니다.

최적화 데모는 다소 간단했지만, 작동 방식은 Omniverse Replicator가 AI를 학습시킬 데이터를 대량으로 생성한 다음 업데이트된 모델을 다운로드하는 것이었습니다. 이 작업은 교육 도구이자 스크립팅 인터페이스를 겸하는 Jupyter Notebook을 통해 진행되었기 때문에 진행 상황을 추적할 수 있었습니다.

훈련 프로세스가 완료되면 최적화된 모델을 다운로드하고 동일한 테스트 비디오에 대해 다시 실행하여 로봇이 낮은 지면에서 볼 수 있는 것을 시뮬레이션할 수 있습니다. 다음 사진에서는 장애물을 훨씬 더 명확하게 볼 수 있으며, 창고 바닥에 있는 사람이 지나가는 로봇에 발가락이 깔릴 가능성이 없습니다.

최적화 후 테스트에서 깜박임이 멈추고 장애물을 선명하게 볼 수 있었습니다.

이 사용 사례에서 AI 모델은 모든 것을 볼 수는 없지만 빠르게 나타났다가 사라지거나 모양이 바뀌는 물체를 볼 수 있었기 때문에 정확도가 약 65%에 불과했습니다. 그러나 옴니버스 리플리케이터의 데이터로 학습 최적화 프로세스가 완료된 후에는 모델이 사물을 명확하게 보고 있다고 훨씬 더 확신하게 되었고, 정확도가 약 95%에 달할 것으로 예상했습니다. 확실히 하려면 로봇에 배포하여 방에 여러 개의 더미를 세워놓고 돌려보는 방법밖에 없었지만, 저희는 그런 장비를 보유하고 있지 않았습니다.

가이드가 있는 연습이라는 점을 감안하면 꽤 쉽게 완료할 수 있었습니다. 하지만 전문 AI 엔지니어가 아닌 저희와 같은 사람들이 이 과정을 통해 무슨 일이 일어나고 있는지 더 잘 이해할 수 있는 방법이었습니다. 최소한 이 도구는 비교적 사용하기 쉬워 보였으며, 생성해야 할 내용을 파악하고 Omniverse Generator에 생성하도록 지시하고 모델을 학습시킨 다음 테스트하기만 하면 됩니다. 물론 많은 시행착오가 수반되겠지만, NVIDIA가 오랫동안 이 프로세스를 반복해 왔기 때문에 반복 작업을 완료하는 것이 그리 어렵지는 않은 것 같습니다.

피플넷 트랜스포머 사용

테스트할 수 있었던 또 다른 사용 사례는 편의점이나 슈퍼마켓의 보안 카메라였습니다. AI는 매장을 통과하는 사람을 식별하고 추적해야 하며, 여러 각도에서 여러 대의 카메라를 통해 추적해야 할 수도 있습니다. 항상 실행할 필요는 없지만, 강도가 발생하면 녹화된 영상에서 AI를 풀어놓는 것이 좋습니다. 피플넷 트랜스포머 모델은 이러한 종류의 작업을 정확히 수행하며, NVIDIA는 이 모델을 사용하여 사람을 식별하는 애플리케이션에 대한 액세스를 제공했습니다.

까꿍! 나 보여요!

이 애플리케이션은 눈에 띄는 사람 주위에 상자를 그려서 줄을 서서 기다리거나 편의점의 통로를 거닐 때 추적합니다. 이 애플리케이션을 Jetson Orin Nano에서 실행할 때 한 가지 단점은 초당 약 7.5프레임으로만 실행되기 때문에 일반적으로 30프레임 또는 심지어 60프레임으로 실행되는 실시간 비디오보다 훨씬 느리다는 것입니다. 더 빠른 모듈(예: 더 큰 개발자 키트에 포함된 32GB Jetson AGX Orin)을 사용하면 적어도 30fps 비디오의 경우 실시간에 가까운 속도로 이 문제를 해결할 수 있습니다. 그러나 데모 목적으로 모든 프레임을 정확하게 처리하지는 못하더라도 AI가 각 프레임에서 사람을 정확하고 빠르게 식별하는 것을 볼 수 있습니다.

Jetson Orin Nano는 작습니다. 정말 작습니다.

Jetson Orin Nano 개발자 키트 주요 내용

NVIDIA는 이미 1년 전에 Jetson AGX Orin에서 인상적인 기능을 개발했지만, 이제 그 방대한 기능을 훨씬 더 저렴하고 전력 효율적인 패키지로 축소했습니다. Jetson Orin Nano 개발자 키트는 창고 로봇 공학이나 컴퓨터 비전 애플리케이션과 같은 AI 엣지 장치에서 볼 수 있을 것입니다. 이 모듈은 저렴한 가격, 강력한 AI 추론 기능, 저전력 요구 사항으로 대규모로 배포하기에 적합합니다.

그러나 더 인상적인 것은 개발자 경험의 근간을 이루는 소프트웨어 스택입니다. AI 교육 자료를 생성하거나 무선으로 업데이트를 빠르고 쉽게 배포하는 도구는 설계에서 구현에 이르는 전체 프로세스를 훨씬 쉽게 관리할 수 있게 해줍니다. 이러한 기능은 우리가 테스트한 다른 로봇 공학 및 컴퓨터 비전 플랫폼에서는 볼 수 없었던 기능으로, 초기 개념에서 실제 작동하는 기계로 전환하는 과정을 가속화하는 데 큰 차이를 만들 수 있습니다. NVIDIA는 엣지 디바이스뿐만 아니라 생성된 트레이닝 콘텐츠와 빠른 모델 트레이닝을 지원하는 클라우드 아키텍처와 같은 매우 편리한 기능을 포함하는 완벽한 로봇 및 비전 AI 소프트웨어 스택을 갖추고 있습니다. 지금까지 경쟁 플랫폼에서 이와 같은 기능은 본 적이 없으며, NVIDIA의 모든 AI 제품에 적용할 수 있습니다.

Jetson AGX Orin 개발자 키트가 모든 기능을 갖추고 있지만 다소 비싼 플랫폼이었다면, Jetson Orin Nano 개발자 키트에 포함된 축소된 버전은 로봇 제작자에게 꼭 필요한 티켓일 수 있습니다. 최근 다른 플랫폼에서 볼 수 있는 것처럼 TSN이나 레거시 IO에 중점을 두지는 않지만, 이러한 IO가 필요하지 않은 애플리케이션이 많이 있습니다. 이러한 유닛 중 하나가 작동할 수 있는 속도까지 더하면 Jetson Orin Nano가 컴퓨터 비전, 로봇 공학 및 AI의 세계에 뛰어들 수 있는 저렴하고 유연하며 강력한 방법이라는 것을 쉽게 알 수 있습니다.

나의 시간과 행복과 즐거움은 돈으로 환산할 수 없다! 질러라!!

https://blog.naver.com/happyshyboy

| 글쓰기 |